当前位置:网站首页>【强化学习笔记】强化学习中的常见符号

【强化学习笔记】强化学习中的常见符号

2022-06-25 07:13:00 【Allenpandas】

| 符号 | 符号释义 |

|---|---|

| ≐ \doteq ≐ | 定义符号 |

| ≈ \approx ≈ | 约等于 |

| ϵ \epsilon ϵ | ϵ \epsilon ϵ贪心策略中随机采取动作的概率 |

| γ \gamma γ | 折扣系数 |

| λ \lambda λ | 迹中的衰减率 |

| ← \leftarrow ← | 赋值符号 |

| s s s, s ′ s' s′ | 状态 s s s |

| a a a | 动作 a a a |

| r r r | 收益 r r r |

| t t t | 离散的时间步,或称为时刻 |

| π \pi π | 策略(决策规则) |

| π ( s ) \pi(s) π(s) | 根据确定性策略 π \pi π 在状态 s s s 时选取的动作 |

| π ( a ∣ s ) \pi(a|s) π(a∣s) | 根据随机性策略 π \pi π 在状态 s s s 时选取的动作 a a a 的概率 |

| A t A_{t} At | t t t 时刻的动作 |

| S t S_{t} St | t t t 时刻的状态,通常由 S t − 1 S_{t-1} St−1 和 A t − 1 A_{t-1} At−1 随机决定 |

| R t R_{t} Rt | t t t 时刻的收益,通常由 S t − 1 S_{t-1} St−1 和 A t − 1 A_{t-1} At−1 随机决定 |

| G t G_t Gt | t t t 时刻的回报(是个期望值) |

| p ( s ′ , r ∣ s , a ) p(s', r |s, a) p(s′,r∣s,a) | 从状态 s s s 采取动作 a a a 转移到状态 s ′ s' s′ 并获得收益 r r r 的概率 |

| p ( s ′ ∣ s , a ) p(s' |s, a) p(s′∣s,a) | 从状态 s s s 采取动作 a a a 转移到状态 s ′ s' s′ 的概率 |

| r ( s , a ) r(s, a) r(s,a) | 从状态 s s s 采取动作 a a a 获得的即时收益的期望 |

| r ( s , a , s ′ ) r(s, a, s') r(s,a,s′) | 从状态 s s s 采取动作 a a a 转移到状态 s ′ s' s′ 获得的即时收益的期望 |

| v π ( s ) v_\pi(s) vπ(s) | 状态 s s s 在策略 π \pi π 下的价值(期望回报) |

| v ∗ ( s ) v_*(s) v∗(s) | 状态 s s s 在最优策略下的价值 |

| q π ( s , a ) q_\pi(s, a) qπ(s,a) | 状态 s s s 在策略 π \pi π 下采取动作 a a a 的价值 |

| q ∗ ( s , a ) q_*(s, a) q∗(s,a) | 状态 s s s 在最优策略下采取动作 a a a 的价值 |

| V V V, V t V_{t} Vt | 状态价值函数 |

| Q Q Q, Q t Q_{t} Qt | 动作价值函数 |

边栏推荐

- 打新债安不安全 有风险吗

- Socket problem record

- Rosparam statement

- Word2vec, phrases, phraser, keyedvectors commonly used in gensim

- 4個不可不知的采用“安全左移”的理由

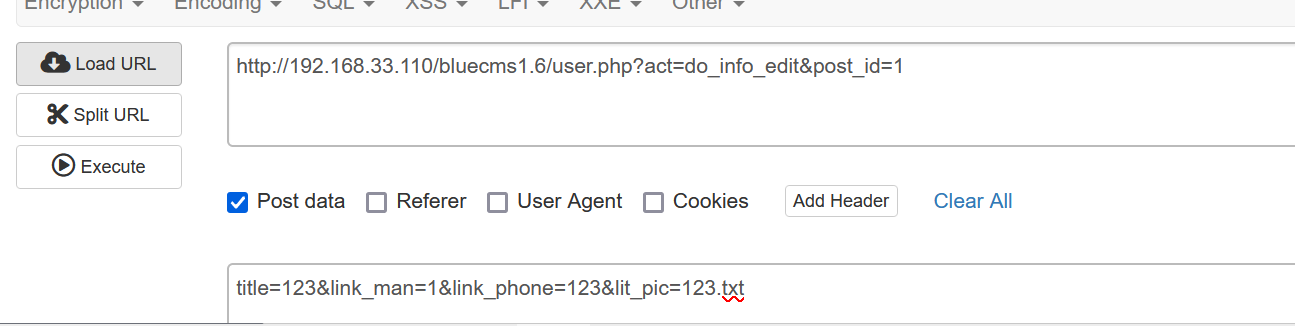

- Bluecmsv1.6-代码审计

- Almost taken away by this wave of handler interview cannons~

- Quickly build a real-time face mask detection system in five minutes (opencv+paddlehub with source code)

- 测一测现在的温度

- Common action types

猜你喜欢

How to calculate the independence weight index?

Data-centric vs. Model-centric. The Answer is Clear!

leetcode.13 --- 罗马数字转整数

使用apt-get命令如何安装软件?

How to calculate the characteristic vector, weight value, CI value and other indicators in AHP?

The era of enterprise full cloud -- the future of cloud database

Super simple case: how to do hierarchical chi square test?

Socket problem record

Bluecmsv1.6-代码审计

What are the indicators of entropy weight TOPSIS method?

随机推荐

第五天 脚本与UI系统

现在网上开通股票账号安全吗?

Find out the possible memory leaks caused by the handler and the solutions

Is there any risk in making new bonds

Apache CouchDB Code Execution Vulnerability (cve-2022-24706) batch POC

Almost taken away by this wave of handler interview cannons~

STM32CubeMX 學習(5)輸入捕獲實驗

417 sequence traversal of binary tree 1 (102. sequence traversal of binary tree, 107. level traversal of binary tree II, 199. right view of binary tree, 637. layer average of binary tree)

Rosparam statement

CVPR 2022 oral 2D images become realistic 3D objects in seconds

Scanpy (VII) spatial data analysis based on scanorama integrated scrna seq

软件测试月薪10K如何涨到30K,只有自动化测试能做到

GIL问题带来的问题,解决方法

2022年毕业生求职找工作青睐哪个行业?

leetcode. 13 --- Roman numeral to integer

Go语言学习教程(十三)

想开个户,网上股票开户安不安全?

初识生成对抗网络(11)——利用Pytorch搭建WGAN生成手写数字

How to calculate the independence weight index?

What are the indicators of entropy weight TOPSIS method?