当前位置:网站首页>2021:Beyond Question-Based Biases:Assessing Multimodal Shortcut Learning in Visual Question Answeri

2021:Beyond Question-Based Biases:Assessing Multimodal Shortcut Learning in Visual Question Answeri

2022-06-27 03:05:00 【weixin_42653320】

摘要

我们介绍了一种视觉问答的评估方法,以更好的诊断捷径(shortcut)学习的案例,当模型利用虚假的统计规律而不是利用期待的行为来产生正确答案时,就会发生这些情况。在现实世界部署模型之前,需要确定数据集中可能的捷径方式,并评估它们的使用。VQA的研究团体专门关注基于问题的捷径,例如,一个模型可能主要依赖之前的问题条件训练,用“blue”回答“What is the color of the sky”,而很少重视视觉证据。我们更进一步考虑同时涉及问题和图像的多模态捷径,我们首先通过挖掘单词和视觉元素同时出现的简单预测规则来确定流行的VQA v2训练集中潜在的捷径方式,然后我们创建VQA-CE--一个由反例组成的新的评估集,如被挖掘的规则会导致错误答案的问题。我们在现有模型的大规模研究中使用这种新的评估方法,我们证明,甚至最先进的模型也表现的很差,而且现有的减少偏见的方法在这种情况下在很大程度上是无效的。我们的发现表明,过去关于VQA基于问题的偏见的工作只解决了一个复杂问题的一方面。

一、介绍

shortcut学习,这些虚假相关性对应于训练数据中的表面统计模式,允许在没有利用期待的行为来预测正确答案。极端情况下,VQA中的shortcut可能在甚至没有看图像的情况下猜答案。一些shortcut可能更微妙的,包含文本和视觉元素,例如,当图像中出现racket(球拍),训练问题中同时包含What sports与答案tennis强烈相关。但是,在验证集中可以找到一些例子,如What sports field is in the background?,这导致一个不同的答案(soccer),尽管图像中存在一个球拍。由于这些例外,强烈依赖简单共现的模型会在不寻常的问题和场景中失败。我们的工作研究了这些多模态模式及其对VQA模型的影响。

对于VQA数据集中的偏见,现有的评估协议仅限于基于文本的shortcut方式,我们的工作介绍了VQA-CounterExamples(VQA-CE for short),一种多模态shortcuts的评估协议,它很容易复制,并且可以在任何在VQA v2的数据集训练的模型上使用,不需要再训练。我们首先从一种方法开始,发现在给定的VQA数据集中可能引起shortcut学习的表面的统计模式,我们发现在训练数据中文本和视觉元素的共现可以预测确定的答案,并且经常转移到验证集中。例如,我们发现一个规则,依赖于词"what","they","playing"和图像中的对象"controller"总能预测正确答案"wii"。我们将这种规则看作shortcut,因为在其他controller的任意图像上失败,就像在现实世界中那样。因此,我们的方法可以用来反应数据集中可能被VQA模型学习到的偏见。

我们进一步在验证集上识别反例,这些反例中shortcut导致错误的答案,这些反例形成一个新的验证集即VQA-CE验证协议。我们发现现有的VQA模型在这个数据上的正确率显著下降,而且,我们发现减少偏见和shortcut的大多现有方法在这种情况下是无效的,他们通常降低整个验证集的平均精度,在反例上没有显著改进。最后,我们确定VQA模型可能利用的shortcut,我们发现了几个与现有模型预测高度相关的预测shortcut。当它们在一些验证集的例子中导致了错误答案,那么VQA模型也提供错误的答案。这表示VQA模型利用了这种多模态shortcut。

本文贡献如下:

1. 我们提出了一种发现shortcut的方法,即依赖于词和视觉元素的出现来预测正确答案,通过应用到广泛使用的VQA v2训练集,我们发现有大量的多模态shortcut可以预测验证集。

2. 我们引入VQA-CE评估协议来评估VQA模型对这些shortcut的依赖性,通过对最近的VQA方法进行大规模的评估,我们发现最新的模型利用了这些shortcut,并且减少偏见的方法在这种情况下无效。

二、相关工作

检测shortcut学习的案例:第一种方法通过利用可解释性的方法检测shortcut的使用,但是需要大量的人类解释或额外的注释;第二种是在人工数据或分布外的数据上评估模型;第三种方法使用已知偏见类型的特定模型评估数据集中这种偏见的数量。以前的工作使用只有问题和只有图像模型来确定单模态shortcut的数量。相反,我们的方法不仅能确定shortcut的数量,还能识别这些shortcut,更重要的是,我们的方法可以识别结合了问题和图像元素的多模态捷径。我们的方法从训练集中提取规则,独立于任何模型,在验证集上评估预测能力。

评估VQA模型对捷径的依赖性:一个捷径的类型确定,第一种评估模型鲁棒性的方法是建立外部的分布外评估数据集,使用这些捷径会导致错误的预测。在VQA中,VQA-Rephrasing数据集包含重新措辞但语义相同的问题,目的是测试模型对于小的语言变化的敏感性,并惩罚使用某类与问题相关的捷径。

另一种评估方法是人类在训练集中注射某种捷径,在不拥有这些捷径的例子上评估模型。广泛使用的VQA-CP评估程序包含重新分割原始VQA数据集,以至于在训练和验证集的每种问题类型的答案分布不同。VQA-CP被用于开发避免学习来自于问题种类的捷径的模型。这类方法的缺点是它们注视于人类引入的捷径,且只关注与文本有关的偏见和捷径,更重要的是,已经在原始数据集上训练过的模型,如VQA v2,需要在他们调整的版本上重新训练,如VQA-CP v2。相反,我们提出的评估方法不需要额外的数据收集或数据生成,关注多模态的捷径,不需要重新训练。

最终,GQA-OOD数据集从GQA验证和测试集实例中基于问题类型提取罕见的答案,因此,它针对的是与问题有关的捷径,它允许在不对单独的训练集重新训练时评估模型。

三、检测VQA的多模态捷径

3.1 我们的捷径检测方法

我们的方法包括构建一个输入-输出变量的数据集,并应用一个规则挖掘算法。VQA通常被认为学习多模态函数f的问题。

对训练集进行挖掘的预测规则:我们的目标是检测f可能用于提供答案的、而不部署所需行为的捷径。为此,我们将自己限制在一类我们认为经常被f利用的捷径上,图2中显示了我们的规则挖掘过程。这些快捷方式是短的预测关联规则A→C,它将前侦探A与后续C关联起来,我们的前身是由问题的单词和图像(或图像补丁)中的突出对象组成的,而我们的后续只是答案。例如,当问题包含“什么”、“颜色”和“植物”时,规则“什么、颜色、植物}→{绿色}提供了“绿色”的答案,这些肤浅的规则是通过构造捷径。它们可以预测验证集,但不能反映在解决VQA任务时需要学习的复杂行为,例如,它们既不依赖于单词的顺序,也不依赖于图像中视觉内容的位置和关系,他们缺乏正确回答这个问题所需的背景,而且,即使是看起来正确的规则在数据集中也有一些反例。i.e.与前因匹配但结果提供了错误的答案。

二值数据集创造:为了检测这些规则,我们首先将Dtrain的所有问答三联体编码为二进制向量。每个维度都解释了(a)问题中的一个词,(b)图像中的一个对象v,用来自Faster的R-CNN的文本检测标签表示,(c)一个答案。每个二进制向量的维数是单词字典的大小之和,所有图像中不同对象的检测标签数,以及训练集中可能的答案的数量。我们报告的结果是用地面真相,而不是在补充材料中检测到的标签。

频繁的临时挖掘:在我们的二进制数据集上,我们应用GMiner算法[12]来有效地寻找频繁的itemsets。项集是一组标记I={i1,..,in}中,它们经常一起出现在数据集中。对项目集的支持是它出现的次数。例如,项目集{什么、颜色、植物、绿色}可能在数据集中非常常见,并且有很高的支持度。GMiner采用一个参数,最小支持。我们包括一个额外的参数,它是一个项集的最大长度。

3.2 对自然数据的快捷方式进行分析

我们分析了我们的方法可以在广泛使用的VQAv2数据集上检测到的快捷方式,我们以最小支持和置信度的不同组合提取捷径。每次,我们都将它们聚合到一个分类器中,并在验证集上进行评估。我们选择以导致最佳的整体准确性的支持和信心。它对应于最小值为2.1·10−5的支持度(在训练集中约为∼8个示例),最小置信度为0.3。一旦检测到这些快捷方式,我们就会评估它们的数量和类型(纯文本、纯视觉或多模态)。我们还验证了它们可以用来找到使用快捷方式无法准确回答的反例。最后,我们评估了它们对验证集的置信度。在下一节中,我们利用VQA-CE评估协议中的这些反例来评估模型对快捷方式的依赖。

仅限文字和仅限对象的快捷方式:首先,我们展示了我们的方法能够检测到纯文本或视觉上的快捷方式。在图3的第一行,我们显示了一个在VQAv2上检测到的快捷方式,它只解释了问题中单词的出现。当单词“什么”、“颜色”、“是”、“雪”出现在问题中的任何位置时,它都会预测答案为“白色”。在训练集中,这些单词出现在95个例子中,其中90.62%的单词有“白色”的答案。这个快捷方式对验证集具有高度的预测性,在92个示例中得到95.65%的正确答案。我们还展示了一个例子,利用快捷方式可以得到正确的答案,和一个反例,快捷方式失败,因为问题是关于“雪套的颜色”,即“粉红色”。在第二行中,我们将显示一个只考虑视觉对象外观的快捷方式。当“飞盘”、“树”、“手”和“帽”出现在图像中时,它会预测“是”。然而,这种快捷方式通常不太具有预测性,因为它们不能利用与某些答案高度相关的问题类型信息。“什么颜色”通常是用一种颜色来回答的。

多模态快捷方式:它们解释了单词和视觉对象的外观。在图3的第三行中,我们显示了一个多模式快捷方式,当什么、运动和球拍出现时预测“网球”。基于训练集中对667个示例的支持,这是一种常见的捷径,置信度为98.05%。它对验证集也具有98.97%的置信度和291的高度预测支持度。乍一看,这个简单的规则是一条捷径,但回答复杂的问题不是关于检测图像中频繁的单词和物体的。事实上,这种快捷方式与它无法准确回答的反例相关联。在这里,可以在背景下进行的运动不是网球,而是足球。

每种类型的快捷方式数和统计数据数:总的来说,它可以检测到VQAv2训练集上的~1.12M快捷方式。如图4所示,由于有~413K示例,因此通常可以对同一示例应用几个快捷方式。这就是大量捷径背后的主要原因,例如,先前{动物,什么,giraffe}和{动物,这些,什么,giraffe}重叠。在我们的方法可以检测到的所有快捷方式中,只有~50k是文本的,~77k是可视化的,~1M是多模态的。换句话说,~90%是多模态的。除了数量多,它们也更有预测性。例如,与图4中用绿色突出显示的示例相匹配的最自信的快捷方式是91.80%的时间是多模态。最后,~3K示例不被任何快捷方式的前例所匹配。他们有不寻常的问题词或视觉内容。我们后来在VQA-CE评估方案中没有考虑到它们。我们在补充材料中展示了一些具有代表性的例子。

训练和看不见数据的置信分布:在补充材料中,我们显示了这些捷径的置信度分布。我们观察到,我们的快捷方式可以++

-预测遵循训练集分布的不可见数据。在验证集上达到0.9到1.0之间的快捷方式的数量在验证集上和在训练集上一样高。这意味着在VQAv2训练集上检测到的快捷方式会转移到验证集。此外,大多数快捷方式获得的置信度低于1.0,这允许通过导致错误的答案来找到与它们相矛盾的示例。这些反例是我们评估VQA模型依赖于快捷方式的方法的核心,下面将进行描述。

四、评估模型对快捷方式的依赖程度

VQA中的经典评估协议包括计算所有示例的平均精度。相反,我们引入VQA反例评估协议(VQA-CE),另外计算验证集的特定子集的平均准确性。这个子集是由不能通过利用快捷方式来回答的反例构成的。利用快捷方式的模型预计的精度会更低。这就是我们评估快捷方式使用的方法。重要的是,我们的协议不需要再训练,就像之前的VQA-CP[1]协议一样。我们首先详细介绍了VQA-CE协议核心的子集创建过程。然后,我们进行了广泛的实验来评估在许多VQA模型和减偏方法上使用的捷径。最后,我们确定了VQA模型经常利用的快捷方式。

4.1 我们的VQA-CE评估协议

使用快捷方式创建子集:通过利用我们之前检测到的快捷方式,我们构建了VQAv2验证集的反例样本子集。这个子集由63,298个例子组成,所有的快捷方式都提供了错误的答案。因此,利用这些快捷方式进行预测的VQA模型将无法得到这类示例的准确答案。他们将受到惩罚,并在这个子集上获得较低的准确性。相反,我们构建了不重叠的Easy子集。它由147,681个例子组成,其中至少有一个快捷方式提供了正确的答案。在这个子集上,利用快捷方式的VQA模型可以达到高精度。最后,3375个示例不与任何快捷方式的前验相匹配,由于这些例子不属于我们的两个子集中的任何一个,因此我们在分析中不考虑它们。

示例的分布:在这里,我们展示了我们的两个子集反例和Easy之间的分裂如何影响示例的分布。在图6中,我们展示了答案的原始分布类似于Easy分布,但不同于反例分布。用蓝色突出显示,我们显示了简单分布中的五个最常见的答案。它们可以在原始分布的相同的位置找到,两个主要答案是“yes”和“no”。在反例子集中,这些答案出现的频率不太高。尽管如此,它们仍然在前30个答案中,这表明我们创建的子集并不是频繁和罕见答案之间的琐碎分裂。类似地,来自反例样本子集中的五个最常见的答案,用橙色突出显示,可以在Easy和所有子集中找到。

4.2 主要结果

在表1中,我们报告了一些基线、常见的VQA模型和遵循我们的VQA-CE评估方案的最新减偏方法的结果。利用快捷方式的模型在反例上的精度有望低于总体精度的模型。所有的模型都在VQAv2训练集上进行训练,在VQAv2验证集上进行评估。

基线:只有问题和只有图像的基线是只使用一种模式的深度模型。它们通常被用来评估深度模型可以捕获的单模态快捷方式的数量。我们报告了与总体精度相比,反例子集的精度极端下降,分别损失了32.53点和22.12点。这表明,大多数只使用问题或图像就容易回答的问题都从我们的反例子集中过滤掉了。

创建分类器的聚合快捷方式:为了评估我们的快捷方式作为一个整体,我们将它们聚合来构建一个VQA分类器。如上一节所示,每个训练示例都与可用于找到正确答案的快捷方式相关联。在这些正确的快捷方式中,我们为每个示例选择最高可信度的一个。这给我们留下了115,718个独特的快捷方式。为了预测一个看不见的例子的答案,我们对其所有匹配的快捷方式采用了最具预测性的答案,这些快捷方式以快捷方式的置信度进行加权。对于没有任何快捷方式匹配的示例,我们输出“yes”,这是最常见的答案。我们的基于快捷方式的分类器的总体准确率为42.26%,接近深度只有问题的基线的44.12%。有趣的是,两者都使用了不同类型的快捷方式。我们的捷径主要基于浅层的多模态捷径,而不仅仅是问题上的捷径。由于我们使用相同的快捷方式来创建子集,基于快捷方式的分类器在反例上达到0%。

VQA模型学习快捷方式:我们比较不同类型的VQA模型:SAN[44]表示图像的网格小补丁和使用堆叠注意机制在这些补丁,而UpDown[3]表示图像作为一组使用Faster-RCNN检测的对象和使用更简单的注意机制,BLOCK[8]也依赖于对象表示但使用一个更复杂的注意机制基于双线性融合,VilBERT[31]也依赖于对象表示,但使用基于transformer的模型预先训练的概念标题数据集[38]。首先,与总体精度相比,他们在反例上损失了~29个精度点。这表明,尽管它们在建模上存在差异,但它们都利用了快捷方式。请注意,在VQACPv2[1]上报告了类似的损失,它特别关注基于问题类型的快捷方式。其次,我们的评估协议可以用于比较两个总体精度相似的模型:UpDown和BLOCK,得到+为0.37分。我们可以解释,这种增益是由于在+为0.96的Easy子集上具有优越的精度,并在反例上报告损失-1.00点。这些结果表明,BLOCK的双线性融合能更好地捕捉捷径。相反,VilBERT在我们的两个子集上都有更好的精度。这可能是由于对外部数据进行预训练的优势。

减少偏见的方法不利于自然的多模态捷径:我们的评估协议也可以用于评估常见的减偏方法的效率。所有研究的方法都应用于UpDown,并在VQA-CP评价集上达到了从+5到+20精度点的增益。我们在原始VQAv2数据集的更真实的上下文中评估它们。我们证明了它们对反例子集的影响非常小。更具体地说,一些方法如RUBi[10]、LMH+RMFE[17]和ESR对所有子集都有负面影响。一些方法,如LMH[13]和LMH+CSS[11],略微提高了反例子集的精度,但大大降低了Easy子集的精度,从而降低了总体精度。正如[43]中报道的,这些方法大多依赖于关于VQA-CP测试分布的知识(基于问题的答案分布的倒置),这不再适用于我们的VQAv2评估设置。最后,我们发现了两种名为LfF[34]和RandImg[43]的方法,它们略微提高了反例子集的精度,+为0.36和+为0.50,而对总体精度的影响很小,甚至在LfF的最佳情况下达到了很小的增益。需要注意的是,LfF比其他的更普遍,因为它不是为特定的VQA-CP上下文设计的。总的来说,与它们对VQA-CP的效果相比,它们的效果要小得多。这表明这些减偏方法可能利用VQA-CP训练和评价分割之间的特定分布转移。它们在这种情况下是有效的,但在减少VQA中自然出现的捷径方面效果并不好。

4.3 确定最被利用的快捷方式

我们介绍了一种方法来识别给定模型可能利用的快捷方式。在验证集上,我们为每个快捷方式计算其答案与所研究模型的预测之间的相关系数。重要的是,100%的相关系数表明模型可能利用快捷方式:两者总是提供相同的答案,即使是在使用快捷方式导致错误答案的反例中。

表2中,我们报告了与UpDown[3]和VilBERT[31]获得最高相关系数的快捷方式。总的来说,这些快捷方式具有很高的置信度和支持度,这意味着它们在数据集中是常见的,并且具有预测性。最重要的是,它们是多模式的。因此,这些快捷方式与只有问题的[21]的相关性较低。相反,他们与VilBERT和UpDown得到了100%的相关系数。例如,第二个快捷方式提供了问题中的sport,this,what和图像中的滑板表面的答案skateboarding。它是一个常见的快捷方式,在验证集中支持31个示例。它的相关性为0%,因为只有问题对这些例子只能回答棒球。其置信度为87.1%,表明在快捷方式提供错误答案时可以找到4个反例。要正确回答,它们需要的不仅仅是基于单词的外观和显著的视觉内容的简单预测。这些结果再次证实了VQA模型倾向于利用多模态捷径。它显示了在VQA的评估方案中考虑到它们的重要性。

五、结论

我们介绍了一种在VQA数据集中发现多模态快捷方式的方法。它对VQA中的快捷方式的本质提供了新的见解:它们不仅与问题有关,而且是多模式的。我们引入了一个评估协议来评估一个给定的模型是否利用了多模态快捷方式。我们发现,大多数最先进的VQA模型在这种设置下都有严重的准确性损失。我们还评估了现有的偏倚减少方法。即使是这些方法的最通用的目的,也没有显著减少多模态快捷方式的使用。我们希望这种新的评估协议将刺激设计更好的技术来学习健壮的VQA模型。

边栏推荐

- Flink学习5:工作原理

- Dameng database installation

- Regular expressions: Syntax

- JWT certification process and use cases

- 栈溢出漏洞

- Yiwen teaches you Kali information collection

- TP5 spreadsheet excel table export

- Super detailed, 20000 word detailed explanation, thoroughly understand es!

- dat. gui. JS star circle track animation JS special effect

- Enterprise digital transformation: informatization and digitalization

猜你喜欢

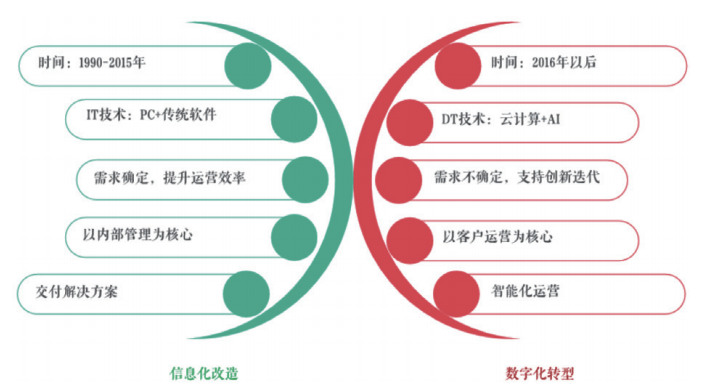

Enterprise digital transformation: informatization and digitalization

超級詳細,2 萬字詳解,吃透 ES!

Career outlook, money outlook and happiness outlook

TechSmith Camtasia latest 2022 detailed function explanation Download

元透实盘周记20220627

QIngScan使用

H5 liquid animation JS special effect code

超级详细,2 万字详解,吃透 ES!

How does source insight (SI) display the full path? (do not display omitted paths) (turn off trim long path names with ellipses)

PAT甲级 1024 Palindromic Number

随机推荐

SQLite reader plug-in tests SQLite syntax

What if asreml-r does not converge in operation?

Lodash get JS code implementation

ConstraintLayout(约束布局)开发指南

2022 operation of simulated examination platform for tea artist (Senior) work license question bank

【一起上水硕系列】Day 6

Uni-app 之uParse 富文本解析 完美解析富文本!

CVPR2022 | PointDistiller:面向高效紧凑3D检测的结构化知识蒸馏

C language -- Design of employee information management system

Microsoft365 developer request

栈溢出漏洞

Parameter estimation -- Chapter 7 study report of probability theory and mathematical statistics (point estimation)

Flink学习3:数据处理模式(流批处理)

TechSmith Camtasia最新2022版详细功能讲解下载

pytorch_grad_cam——pytorch下的模型特征(Class Activation Mapping, CAM)可视化库

Flink学习2:应用场景

Canvas particles: mouse following JS effect

学习太极创客 — MQTT 第二章(三)保留消息

超级详细,2 万字详解,吃透 ES!

Pat grade a 1018 public bike management