当前位置:网站首页>[Batch dos - cmd Command - Summary and Summary] - External Command - cmd Download Command, wget Command

[Batch dos - cmd Command - Summary and Summary] - External Command - cmd Download Command, wget Command

2022-06-25 07:27:00 【Dssgresadfsrgre】

Un.、wgetAvantages du téléchargement de programmes

1)Prise en charge de la fonction de transfert descendant du point d'arrêt

2)Soutien simultanéFTPEtHTTPMode de téléchargement

3)Prise en charge des serveurs Proxy

4)Facile à installer

5)Petit programme,Entièrement gratuit

2.、Téléchargement et installationwgetProcédure

wgetLe site Web de:Wget for Windows

Mais bizarrement, Tous les liens de téléchargement,Tout est là.301Erreur.

J'ai donc dû changer de site pour le télécharger,Sites recommandésGNU Wget 1.21.3 for Windows

Je l'ai téléchargé.1.21.3 De64Version bitzipPackage.

Après décompression,Déplacer ce dossier dans son ensemble verscSous disquesystem32Sous la table des matières,Configurer les variables d'environnement,C'est - à - dire que l'installation est terminée.

Trois、wgetUtilisation des commandes

3.1 wgetInformations d'aide pour la commande——wget --help

Si c'est normal d'exécuter cette commande , Cela signifie que l'installation a été réussie ,Si une erreur est signalée——wgetNi interne ni externe, Donc l'installation a échoué .

Souvent, il y a un problème avec la configuration de vos variables d'environnement .

C:\Users\Administrator>wget --help

GNU Wget 1.21.3, a non-interactive network retriever.

Usage: wget [OPTION]... [URL]...

Mandatory arguments to long options are mandatory for short options too.

Startup:

-V, --version display the version of Wget and exit

-h, --help print this help

-b, --background go to background after startup

-e, --execute=COMMAND execute a `.wgetrc'-style command

Logging and input file:

-o, --output-file=FILE log messages to FILE

-a, --append-output=FILE append messages to FILE

-d, --debug print lots of debugging information

-q, --quiet quiet (no output)

-v, --verbose be verbose (this is the default)

-nv, --no-verbose turn off verboseness, without being quiet

--report-speed=TYPE output bandwidth as TYPE. TYPE can be bits

-i, --input-file=FILE download URLs found in local or external FILE

--input-metalink=FILE download files covered in local Metalink FILE

-F, --force-html treat input file as HTML

-B, --base=URL resolves HTML input-file links (-i -F)

relative to URL

--config=FILE specify config file to use

--no-config do not read any config file

--rejected-log=FILE log reasons for URL rejection to FILE

Download:

-t, --tries=NUMBER set number of retries to NUMBER (0 unlimits)

--retry-connrefused retry even if connection is refused

--retry-on-http-error=ERRORS comma-separated list of HTTP errors to retry

-O, --output-document=FILE write documents to FILE

-nc, --no-clobber skip downloads that would download to

existing files (overwriting them)

--no-netrc don't try to obtain credentials from .netrc

-c, --continue resume getting a partially-downloaded file

--start-pos=OFFSET start downloading from zero-based position OFFSET

--progress=TYPE select progress gauge type

--show-progress display the progress bar in any verbosity mode

-N, --timestamping don't re-retrieve files unless newer than

local

--no-if-modified-since don't use conditional if-modified-since get

requests in timestamping mode

--no-use-server-timestamps don't set the local file's timestamp by

the one on the server

-S, --server-response print server response

--spider don't download anything

-T, --timeout=SECONDS set all timeout values to SECONDS

--dns-servers=ADDRESSES list of DNS servers to query (comma separated)

--bind-dns-address=ADDRESS bind DNS resolver to ADDRESS (hostname or IP) on local host

--dns-timeout=SECS set the DNS lookup timeout to SECS

--connect-timeout=SECS set the connect timeout to SECS

--read-timeout=SECS set the read timeout to SECS

-w, --wait=SECONDS wait SECONDS between retrievals

(applies if more then 1 URL is to be retrieved)

--waitretry=SECONDS wait 1..SECONDS between retries of a retrieval

(applies if more then 1 URL is to be retrieved)

--random-wait wait from 0.5*WAIT...1.5*WAIT secs between retrievals

(applies if more then 1 URL is to be retrieved)

--no-proxy explicitly turn off proxy

-Q, --quota=NUMBER set retrieval quota to NUMBER

--bind-address=ADDRESS bind to ADDRESS (hostname or IP) on local host

--limit-rate=RATE limit download rate to RATE

--no-dns-cache disable caching DNS lookups

--restrict-file-names=OS restrict chars in file names to ones OS allows

--ignore-case ignore case when matching files/directories

-4, --inet4-only connect only to IPv4 addresses

-6, --inet6-only connect only to IPv6 addresses

--prefer-family=FAMILY connect first to addresses of specified family,

one of IPv6, IPv4, or none

--user=USER set both ftp and http user to USER

--password=PASS set both ftp and http password to PASS

--ask-password prompt for passwords

--use-askpass=COMMAND specify credential handler for requesting

username and password. If no COMMAND is

specified the WGET_ASKPASS or the SSH_ASKPASS

environment variable is used.

--no-iri turn off IRI support

--local-encoding=ENC use ENC as the local encoding for IRIs

--remote-encoding=ENC use ENC as the default remote encoding

--unlink remove file before clobber

--keep-badhash keep files with checksum mismatch (append .badhash)

--metalink-index=NUMBER Metalink application/metalink4+xml metaurl ordinal NUMBER

--metalink-over-http use Metalink metadata from HTTP response headers

--preferred-location preferred location for Metalink resources

Directories:

-nd, --no-directories don't create directories

-x, --force-directories force creation of directories

-nH, --no-host-directories don't create host directories

--protocol-directories use protocol name in directories

-P, --directory-prefix=PREFIX save files to PREFIX/..

--cut-dirs=NUMBER ignore NUMBER remote directory components

HTTP options:

--http-user=USER set http user to USER

--http-password=PASS set http password to PASS

--no-cache disallow server-cached data

--default-page=NAME change the default page name (normally

this is 'index.html'.)

-E, --adjust-extension save HTML/CSS documents with proper extensions

--ignore-length ignore 'Content-Length' header field

--header=STRING insert STRING among the headers

--compression=TYPE choose compression, one of auto, gzip and none. (default: none)

--max-redirect maximum redirections allowed per page

--proxy-user=USER set USER as proxy username

--proxy-password=PASS set PASS as proxy password

--referer=URL include 'Referer: URL' header in HTTP request

--save-headers save the HTTP headers to file

-U, --user-agent=AGENT identify as AGENT instead of Wget/VERSION

--no-http-keep-alive disable HTTP keep-alive (persistent connections)

--no-cookies don't use cookies

--load-cookies=FILE load cookies from FILE before session

--save-cookies=FILE save cookies to FILE after session

--keep-session-cookies load and save session (non-permanent) cookies

--post-data=STRING use the POST method; send STRING as the data

--post-file=FILE use the POST method; send contents of FILE

--method=HTTPMethod use method "HTTPMethod" in the request

--body-data=STRING send STRING as data. --method MUST be set

--body-file=FILE send contents of FILE. --method MUST be set

--content-disposition honor the Content-Disposition header when

choosing local file names (EXPERIMENTAL)

--content-on-error output the received content on server errors

--auth-no-challenge send Basic HTTP authentication information

without first waiting for the server's

challenge

HTTPS (SSL/TLS) options:

--secure-protocol=PR choose secure protocol, one of auto, SSLv2,

SSLv3, TLSv1, TLSv1_1, TLSv1_2, TLSv1_3 and PFS

--https-only only follow secure HTTPS links

--no-check-certificate don't validate the server's certificate

--certificate=FILE client certificate file

--certificate-type=TYPE client certificate type, PEM or DER

--private-key=FILE private key file

--private-key-type=TYPE private key type, PEM or DER

--ca-certificate=FILE file with the bundle of CAs

--ca-directory=DIR directory where hash list of CAs is stored

--crl-file=FILE file with bundle of CRLs

--pinnedpubkey=FILE/HASHES Public key (PEM/DER) file, or any number

of base64 encoded sha256 hashes preceded by

'sha256//' and separated by ';', to verify

peer against

--random-file=FILE file with random data for seeding the SSL PRNG

--ciphers=STR Set the priority string (GnuTLS) or cipher list string (OpenSSL) directly.

Use with care. This option overrides --secure-protocol.

The format and syntax of this string depend on the specific SSL/TLS engine.

HSTS options:

--no-hsts disable HSTS

--hsts-file path of HSTS database (will override default)

FTP options:

--ftp-user=USER set ftp user to USER

--ftp-password=PASS set ftp password to PASS

--no-remove-listing don't remove '.listing' files

--no-glob turn off FTP file name globbing

--no-passive-ftp disable the "passive" transfer mode

--preserve-permissions preserve remote file permissions

--retr-symlinks when recursing, get linked-to files (not dir)

FTPS options:

--ftps-implicit use implicit FTPS (default port is 990)

--ftps-resume-ssl resume the SSL/TLS session started in the control connection when

opening a data connection

--ftps-clear-data-connection cipher the control channel only; all the data will be in plaintext

--ftps-fallback-to-ftp fall back to FTP if FTPS is not supported in the target server

WARC options:

--warc-file=FILENAME save request/response data to a .warc.gz file

--warc-header=STRING insert STRING into the warcinfo record

--warc-max-size=NUMBER set maximum size of WARC files to NUMBER

--warc-cdx write CDX index files

--warc-dedup=FILENAME do not store records listed in this CDX file

--no-warc-compression do not compress WARC files with GZIP

--no-warc-digests do not calculate SHA1 digests

--no-warc-keep-log do not store the log file in a WARC record

--warc-tempdir=DIRECTORY location for temporary files created by the

WARC writer

Recursive download:

-r, --recursive specify recursive download

-l, --level=NUMBER maximum recursion depth (inf or 0 for infinite)

--delete-after delete files locally after downloading them

-k, --convert-links make links in downloaded HTML or CSS point to

local files

--convert-file-only convert the file part of the URLs only (usually known as the basename)

--backups=N before writing file X, rotate up to N backup files

-K, --backup-converted before converting file X, back up as X.orig

-m, --mirror shortcut for -N -r -l inf --no-remove-listing

-p, --page-requisites get all images, etc. needed to display HTML page

--strict-comments turn on strict (SGML) handling of HTML comments

Recursive accept/reject:

-A, --accept=LIST comma-separated list of accepted extensions

-R, --reject=LIST comma-separated list of rejected extensions

--accept-regex=REGEX regex matching accepted URLs

--reject-regex=REGEX regex matching rejected URLs

--regex-type=TYPE regex type (posix|pcre)

-D, --domains=LIST comma-separated list of accepted domains

--exclude-domains=LIST comma-separated list of rejected domains

--follow-ftp follow FTP links from HTML documents

--follow-tags=LIST comma-separated list of followed HTML tags

--ignore-tags=LIST comma-separated list of ignored HTML tags

-H, --span-hosts go to foreign hosts when recursive

-L, --relative follow relative links only

-I, --include-directories=LIST list of allowed directories

--trust-server-names use the name specified by the redirection

URL's last component

-X, --exclude-directories=LIST list of excluded directories

-np, --no-parent don't ascend to the parent directory

Email bug reports, questions, discussions to <[email protected]>

and/or open issues at https://savannah.gnu.org/bugs/?func=additem&group=wget.

3.2 wgetUtilisation de base de la commande——wget site

Disons que nous allons télécharger B Photo de couverture d'une vidéo debout ,On peut exécuter les ordres.【wget https://i2.hdslb.com/bfs/archive/[email protected]_378h_1c.webphttps://funimg.pddpic.com/ddjb/2020-09-16/804f5f88-82d4-4b3f-9cfe-06d4d172fec3.png.slim.pnghttps://i2.hdslb.com/bfs/archive/[email protected]_378h_1c.webp】.

Téléchargement réussi.

In2345 Regarde, Wang, ouvre ça. webpFormat de l'image, Normal. .

Attention!: Toutes les images ne supportent pas wgetTéléchargement des commandes,Comme Google.logo Le lien image est https://www.google.com/images/branding/googlelogo/2x/googlelogo_color_92x30dp.png

,Nous utilisonswget Lorsque la commande est téléchargée , Le serveur Discovery a refusé de répondre .

Mais nous utilisons notre navigateur pour accéder directement à ce lien ,C'est normal..

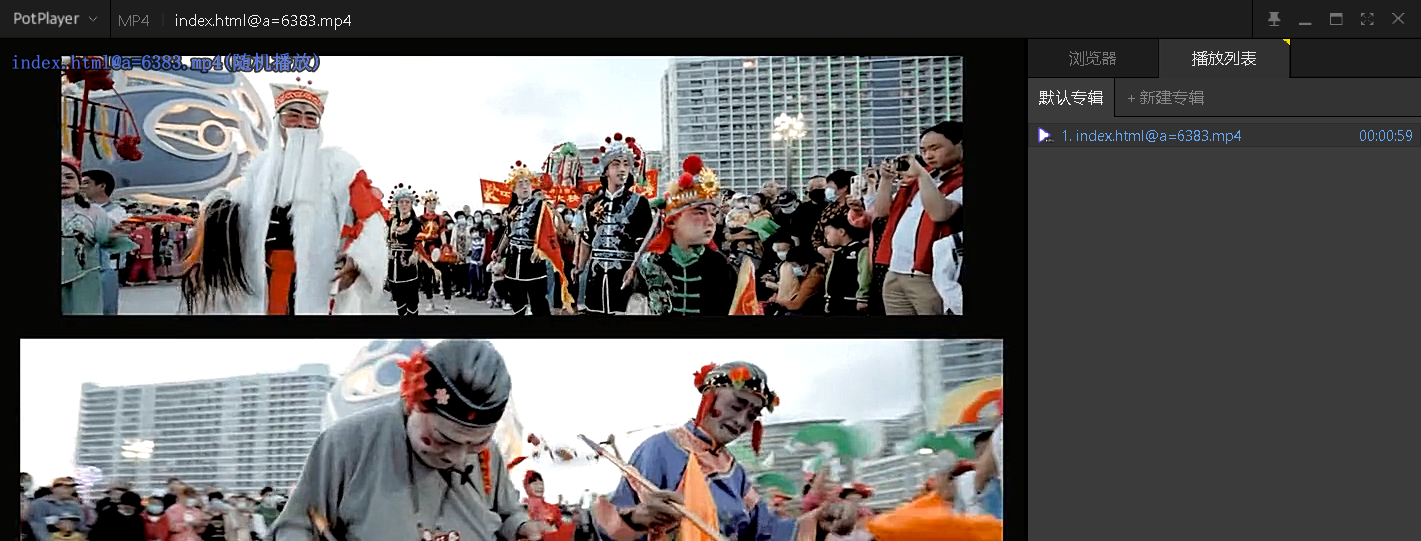

Ce qui vient d'être téléchargé est l'image , Essayons une vidéo. 【https://v26-web.douyinvod.com/0a9c9db510fa69375b8ca201d682aee5/62b59bc7/video/tos/cn/tos-cn-ve-15c001-alinc2/8d2c907ce7144fa8ad9fe39fff903e1b/?a=6383&ch=5&cr=0&dr=0&lr=all&cd=0%7C0%7C0%7C0&cv=1&br=3130&bt=3130&cs=0&ds=6&ft=5q_lc5mmnPKe2N4EqM9wTqdlYhd.YPjcTR3-&mime_type=video_mp4&qs=0&rc=Nmg5Ojc7NDU0NDVoaGk0PEBpM2Q5Njo6Zjs7ZDMzNGkzM0A0L2MvNGA2XjYxMV5hNDViYSM1bWlwcjQwcl5gLS1kLS9zcw%3D%3D&l=20220624181002010208016205390882DC】

Ce qui vient d'être téléchargé est l'image , Essayons une vidéo. 【https://v26-web.douyinvod.com/0a9c9db510fa69375b8ca201d682aee5/62b59bc7/video/tos/cn/tos-cn-ve-15c001-alinc2/8d2c907ce7144fa8ad9fe39fff903e1b/?a=6383&ch=5&cr=0&dr=0&lr=all&cd=0%7C0%7C0%7C0&cv=1&br=3130&bt=3130&cs=0&ds=6&ft=5q_lc5mmnPKe2N4EqM9wTqdlYhd.YPjcTR3-&mime_type=video_mp4&qs=0&rc=Nmg5Ojc7NDU0NDVoaGk0PEBpM2Q5Njo6Zjs7ZDMzNGkzM0A0L2MvNGA2XjYxMV5hNDViYSM1bWlwcjQwcl5gLS1kLS9zcw%3D%3D&l=20220624181002010208016205390882DC】

Téléchargement réussi.

Le fichier téléchargé doit être complété par une extension .

Après extension supplémentaire ,Ouvre.,Très réussi..

Enfin, Nous essayons de télécharger la page web , Comme Baidu Search Home Page , Exécutez les ordres. 【wget www.baidu.com】.

Après le téléchargement dans le répertoire courant , Allons l'ouvrir. ? C'est bon. .

3.3 Télécharger la sortie du Journal vers le fichier cible ——Paramètres-o(Minuscule)

Paramètres de la version abrégée -o La version longue de --output-file, Supposons donc que nous voulions télécharger la page de recherche Baidu , Alors nous pouvons exécuter les ordres 【wget -o log.txt www.baidu.com】Ou【wget --output-file=log.txt www.baidu.com】.

Après l'exécution de la commande, Un fichier journal a été ajouté dans le répertoire courant 、UnhtmlDocumentation, Mais le journal n'apparaît pas dans cmd Dans la fenêtre. .

3.4 Extrait en vrac d'un fichier texte url——Paramètres-i

Paramètres de la version abrégée -i La version longue de --input-file, Supposons donc que nous voulions télécharger un lot de ressources , Et ces ressources url Stocker dans un fichier texte , Alors nous pouvons exécuter les ordres 【wget -i url.txt】Ou【wget --input-file=url.txt】.

Créer un nouveautxtDocumentation, Il y a deux lignes dedans. url.

Exécuter les commandes 【wget -i url.txt】,Téléchargement réussi.

3.5 Télécharger et renommer ——Paramètres-O(En majuscules)

À partir des sections ci - dessus , C'est facile à trouver. “ Si vous ne nommez pas activement les fichiers de ressources téléchargés , Le programme ajoute automatiquement html Extension ou non ”.

Donc,, Pour éviter des renommages ultérieurs dans l'explorateur , Nous pouvons le faire directement en exécutant la commande de téléchargement .

Paramètres de la version abrégée -O La version longue de --output-document, Si vous souhaitez télécharger et renommer ,Peut exécuter des commandes【wget -O filename url】Ou【wget --output-document=filename url】.

Exécuter les commandes【wget -O baidu.html www.baidu.com】.

Si vous voulez que le répertoire spécifié existe , Et renommer le fichier , Alors vous pouvez écrire 【wget -O filepath url】Forme,Parmi euxfilepath Le dernier paragraphe devrait être un nom de fichier .

Visible,-O Les paramètres ne peuvent pas seulement être renommés , Vous pouvez également implémenter les paramètres mentionnés ci - dessous -PLa fonction de.

3.6 Télécharger dans le dossier spécifié ——Paramètres-P(En majuscules)

Paramètres de la version abrégée -P La version longue de --directory-prefix, Supposons donc que nous Téléchargeons la ressource dans le dossier spécifié , Alors nous pouvons exécuter les ordres 【wget -O directory url】Ou【wget --directory-prefix=directory url】.

Enregistrer les ressources téléchargées dans le répertoire webpage( Peut être un répertoire qui n'existe pas )En bas.,Exécuter les commandes【wget -P webpage www.baidu.com】.

3.7 Téléchargement récursif de l'ensemble du site——Paramètres-r

Paramètres de la version abrégée -r La version longue de --recursive, Supposons donc que nous voulions télécharger toutes les ressources du site correspondant , Alors nous pouvons exécuter les ordres 【wget -r url】Ou【wget --recursive url】.

Essayez. CSDN Ramper sur le site Web de , Parce que les ressources téléchargées sont sauvegardées à urlDans un dossier nommé, Alors exécutez les ordres. 【wget -r www.csdn.net】 Vous n'avez pas à vous soucier de la confusion avec d'autres fichiers après le téléchargement .

Après l'exécution, Nous avons trouvé seulement deux fichiers téléchargés , Un de ces noms est robot.txtDocuments,DescriptionCSDN Il y a un mécanisme anti - crawler sur le site , Après tout, c'est une grande station commerciale. ,C'est pas vrai....

Essayons de grimper quelques petites stations , Par exemple, le site officiel d'une université bien connue à Pékin ( Voici un Conseil chaleureux ,Ne fais pas de bêtises, Si tu n'avais pas eu de problème , Il y a un problème. ,Ça a mal tourné., Attention à ce que l'université vous envoie une lettre d'avocat , Alors ne Grimpez pas , Essaie. ).

Exécuter les commandes【wget -r www.tsinghua.edu.cn】,Et puis nous pouvons voircmd La fenêtre continue de défiler , Ce site n'a pas de mécanisme anti - crawler .

Mais pour ne pas vouloir trop “Peine”Considérations, J'appuie quand même. ctrl+c La clé a arrêté le crawler. , Les fichiers de ressources téléchargés sont présentés ci - dessous .

Mais pour ne pas vouloir trop “Peine”Considérations, J'appuie quand même. ctrl+c La clé a arrêté le crawler. , Les fichiers de ressources téléchargés sont présentés ci - dessous .

Quatre、C'est exact.Cmd Résumé et réflexion des ordres

Utilisez - le là - haut.wget Paramètres de la paire de commandes -i Lors de l'expérience , J'ai découvert que l'exécution des ordres 【wget -i=url.txt】 Impossible de trouver le fichier .

Et puis,Après un certain temps, J'ai lu d'autres articles en ligne qui ont une version abrégée de ce paramètre 、 Il y a aussi des cas de version longue , La valeur du paramètre doit de préférence être séparée du paramètre par un espace .

Parce que pour la version abrégée , Les paramètres et les valeurs des paramètres ne peuvent pas être séparés par un signe égal , Mais on peut les séparer par des espaces ; Pour les versions longues , Les paramètres et les valeurs des paramètres peuvent être séparés par un signe égal ou un espace .

Si une syntaxe inappropriée est utilisée , La valeur du paramètre est incorrectement attribuée au paramètre .

Comme exécuter des ordres【wget -o=log.txt www.baidu.com】Après, Le nom du fichier journal généré n'est pas “log.txt”,Et ça s'appelle“=log.txt”.

边栏推荐

- MCU IO explanation (pull-up pull-down quasi bidirectional input / output push-pull open drain)

- Lotus windowsost manually triggers space-time proof calculation

- 弱大数定理的意义与证明

- Make fertilizer Safi from crop residues locally to increase yield by 30% and improve soil

- Redirect to previous page after login? PHP - Redirecting to previous page after login? PHP

- Escape analysis of 982 golang

- Several schemes of traffic exposure in kubernetes cluster

- 用动图讲解分布式 Raft

- What is the new business model of Taishan crowdfunding in 2022?

- 正版photoshop2022購買體驗經曆分享

猜你喜欢

48 张图 | 手摸手教你微服务的性能监控、压测和调优

诸葛亮 VS 庞统,拿下分布式 Paxos

The king scheme in distributed locks - redisson

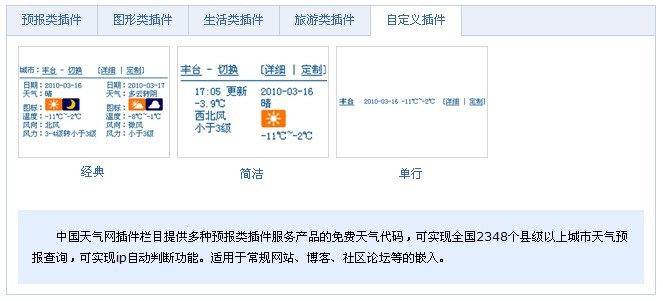

几款不错的天气插件

![[introduction to UVM== > episode_9] ~ register model, integration of register model, general methods of register model, application scenarios of register model](/img/c0/b373a3f0e0c7b35f42c8a28b4d4f74.png)

[introduction to UVM== > episode_9] ~ register model, integration of register model, general methods of register model, application scenarios of register model

分布式锁中的王者方案 - Redisson

Rotation vector (rotation matrix) and Euler angle

Loopholes in the missed scanning system of Lvmeng and its repair scheme

活动报名|Apache Pulsar x KubeSphere 在线 Meetup 火热来袭

![[he doesn't mention love, but every word is love]](/img/28/0c3ddad3dc9b1ef8d0618164f39e53.png)

[he doesn't mention love, but every word is love]

随机推荐

StreamNative Platform 1.5 版本发布,集成 Istio、支持 OpenShift 部署

How do I create a guid in excel- How to create a GUID in Excel?

Blue Bridge Cup SCM module code (nixie tube) (code + comments)

The significance and proof of weak large number theorem

【UVM入门 ===> Episode_9 】~ 寄存器模型、寄存器模型的集成、寄存器模型的常规方法、寄存器模型的应用场景

Lotus v1.16.0-rc2 Calibration net

Changing the background color of tab bar - changing the background color of tab bar

13 `bs_duixiang.tag标签`得到一个tag对象

Keepalived monitors the process and automatically restarts the service process

[C language] add separator to string

Lotus windowsost manually triggers space-time proof calculation

How do I get red green blue (RGB) and alpha back from a UIColor object?

Efficient exploration | an application practice of ES geographical location query

Flexbox on ie11: stretching images for no reason- Flexbox on IE11: image stretched for no reason?

How to get the difference between two dates rounded to hours

Authentique Photoshop 2022 expérience d'achat partage

Loopholes in the missed scanning system of Lvmeng and its repair scheme

[tool sharing] a software that pays equal attention to appearance and skills

Pratique de gestion hiérarchique basée sur kubesphere

The e-book "action guide for large organizations to further promote zero code application platform" was officially released!