当前位置:网站首页>多模态数据也能进行MAE?伯克利&谷歌提出M3AE,在图像和文本数据上进行MAE!最优掩蔽率可达75%,显著高于BERT的15%

多模态数据也能进行MAE?伯克利&谷歌提出M3AE,在图像和文本数据上进行MAE!最优掩蔽率可达75%,显著高于BERT的15%

2022-06-24 21:33:00 【智源社区】

本文分享论文『Multimodal Masked Autoencoders Learn Transferable Representations』,思考:多模态数据也能进行MAE?UC Berkeley&Google提出M3AE,在图像和文本数据上进行MAE!文本的最优掩蔽率可达75%,显著高于BERT的15%!

详细信息如下:

构建可扩展的模型以从多样化、多模态的数据中学习仍然是一个开放的挑战。对于视觉语言数据,主要的方法是基于对比学习目标,即为每个模态训练单独的编码器。虽然有效,但对比学习方法会根据使用的数据增加引入抽样偏差,这会降低下游任务的性能。此外,这些方法仅限于成对的图像文本数据,无法利用广泛可用的未成对数据。

在本文中,作者研究了一个仅通过掩蔽token预测训练的大型多模态模型,在不使用模态特定编码器或对比学习的情况下,可以学习下游任务的可迁移表示。作者提出了一种简单且可扩展的网络架构,即多模态掩蔽自动编码器(Multimodal Masked Autoencoder,M3AE),它通过掩蔽token预测学习视觉和语言数据的统一编码器。

作者对在大规模图像文本数据集上训练的M3AE进行了实证研究,发现M3AE能够学习可迁移的表示,并能很好地迁移给下游任务。由于两种数据模式的联合训练,与标准掩蔽率为15%的BERT相比,M3AE受益于更高的文本掩蔽率(50-90%)。作者还提供了定性分析,表明学习到的表征融合了来自图像和语言的有意义信息。最后,作者展示了M3AE的可扩展性,它具有更大的模型大小和训练时间,以及在成对图像文本数据和未成对数据上训练的灵活性。

边栏推荐

猜你喜欢

Deploy a production cluster using Loki microservice pattern

带马尔科夫切换的正向随机微分方程数值格式模拟

第04天-文件IO

pbcms添加循环数字标签

Q1季度逆势增长的华为笔电,正引领PC进入“智慧办公”时代

The innovation consortium of Haihe laboratory established gbase and became one of the first member units of the innovation Consortium (Xinchuang)

Introduction to bi-sql wildcards

【LeetCode】11、盛最多水的容器

汇编语言(2)基础知识-debug

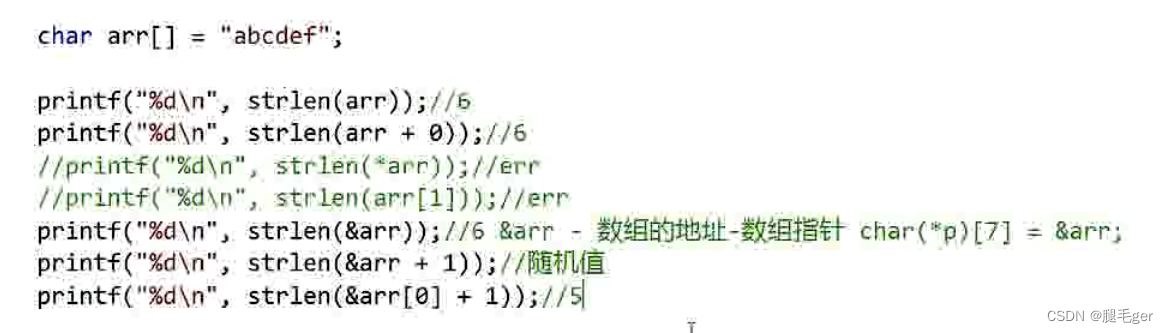

数组中关于sizeof()和strlen

随机推荐

Expectation and variance

Bi skill - judge 0 and null

PHP 利用getid3 获取mp3、mp4、wav等媒体文件时长等数据

‘distutils‘ has no attribute ‘version

sql 聚合函数有哪些

搜索二维矩阵[二分巧用 + 记录不同于插入二分的解法]

JVM指令

"One good programmer is worth five ordinary programmers!"

The latest QQ wechat domain name anti red PHP program source code + forced jump to open

期望与方差

第04天-文件IO

yasea apk 下载 镜像

Q1季度逆势增长的华为笔电,正引领PC进入“智慧办公”时代

云开发技术峰会·公益编程挑战赛【火热报名中】!

天书夜读笔记——内存分页机制

Bi-sql select into

卷积与转置卷积

Bi SQL alias

excel 汉字转拼音「建议收藏」

纹理增强