当前位置:网站首页>biggan:large scale gan training for high fidelity natural image synthesis

biggan:large scale gan training for high fidelity natural image synthesis

2022-06-26 00:04:00 【Kun Li】

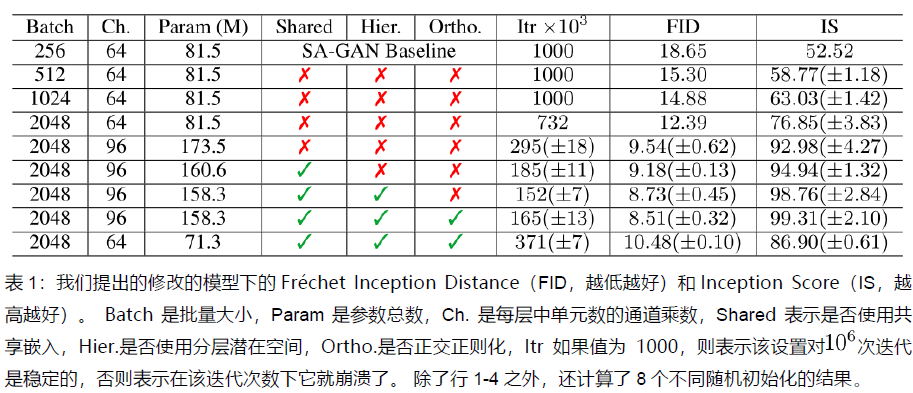

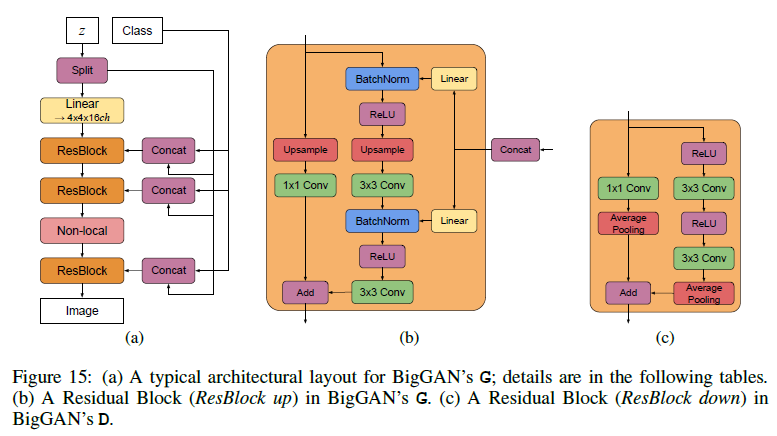

深度解读DeepMind新作:史上最强GAN图像生成器—BigGAN - 知乎本期推荐的论文笔记来自 PaperWeekly 社区用户 @TwistedW。由 DeepMind 带来的 BigGAN 可谓是笔者见过最好的 GAN 模型了,这里的 Big 不单单是指模型参数和 Batch 的大,似乎还在暗示让人印象深刻,文章也确实做到… https://zhuanlan.zhihu.com/p/46581611这篇文章写的还是很容易理解的,相比较之前大规模的摆公式,biggan好理解多了,但是模型结构图都放到了附录中了,biggan的核心有三点,第一更大了,大bs和大参数,第二,来源于对模型的调整,比如latent的分层输入,贡献c,第三latent z的截断输入,为了应对这种截断输入,提出了正交正则化,最后基于训练不稳定提了一些改进的技巧。

https://zhuanlan.zhihu.com/p/46581611这篇文章写的还是很容易理解的,相比较之前大规模的摆公式,biggan好理解多了,但是模型结构图都放到了附录中了,biggan的核心有三点,第一更大了,大bs和大参数,第二,来源于对模型的调整,比如latent的分层输入,贡献c,第三latent z的截断输入,为了应对这种截断输入,提出了正交正则化,最后基于训练不稳定提了一些改进的技巧。

1.introduction

gan从尺度缩放中受益,与现有技术相比,训练参数为2-4倍,batch大8倍,达到了2048这个级别,对应到题目的large scale,其实biggan发现只是单纯的调大规模,gan就能有更好的效果。作为修改的副作用,模型变得适合截断技巧,truncation trick,这是一种简单的采样技术,可以对样本种类和保真度之间的权衡进行明确,细粒度的控制。

2.background

3.scaling up gans

探索扩大gan训练的方法,以获得在larger models和larger batch下的优势。使用SAGAN架构,hinge loss,条件bn的G,含投影的D,谱归一化,moving averages of G weights,正交初始化。

首先增加baseline model的bs,IS很快提高,但是副作用是我们的模型在更少的迭代中更好,但是变得不稳定且易模式崩溃。

宽度增加50%,效果继续提升。

看上图,c是共享的,对latent z进行split,噪声向量z被馈送入多个层而不仅仅是初始层,这个是很有意义的,在stylegan中也是这么做的,latent z其实对生成器中每一个卷积层都有用,卷积层其实是从粗糙到精细化的过程,从latent z空间采样,这种设计的背后直觉是允许生成器使用潜在空间直接影响不同分辨率和层次结构结构级别的特征。在bigan中,将z分成每个分辨率的一块,并将每个块链接到条件向量c,条件向量c映射到BN的增益和偏差。

3.1 trading off variety and fidelity with the truncation trick

gan可以使用任意的先验,但绝大多数使用的是高斯和均匀分布,可以有更好的替代方案。所谓截断技巧,就是通过对从先验分布z采样,通过设置阈值的方式来截断z的采样,其中超出范围的值被重新采样已落入该范围,这个阈值可以根据生成质量指标IS和FID决定。这个实验可以知道通过对阈值的设定,随着阈值的下降生成的质量会越来越好,但是由于阈值的下降,采样的范围变窄,就会造成生成上取向单一化,造成生成的多样性不足的问题。

上图中a就是随着阈值越来越低,效果确实越来越好,但是越来越单一,b图是大模型其实不适合截断,容易出现饱和伪影。为了抵消这种情况,我们试图将G调节为平滑来强制实现截断的适应性,以便z的整个空间到良好的输出样本。采样正交正则化。

4.analysis

主要是分析了gan在训练期间不稳定的原因,并在生成器和判别器上做了一些限制。

边栏推荐

猜你喜欢

Oracle数据库开启备份准备工作

MySQL book borrowing system project database creation TABLE statement (combined primary key and foreign key settings)

CityJSON

21. Hoff circle transformation

热血男孩滕文泽 受邀担任第六季完美童模全球总决赛形象大使

浅谈接口测试(二)

Postman斷言對應脚本的解釋

Shell regular expression

Region of Halcon: generation of multiple regions (4)

Embedded c learning notes

随机推荐

完整复习(包含语法)--MYSQL正则表达式

20. Hough line transformation

Forgotten Jieba participle

NLP enhanced technology

readv & writev

图文大师印章简易制作

Viwi interface

Android system startup security

GUN make (5) makefile中的变量

Shengxin weekly issue 34

JSON introduction

木瓜蛋白酶的特点及相关特异性介绍

浅谈接口测试(二)

GUN make (2) 总述

"Hot post" Statistics

**MySQL例题一(根据不同问题,多条件查询)**

Laravel基础课 路由和MVC——路由

Assertion of postman interface test

Talking about interface test (I)

Worthington胶原蛋白酶的多类型研究