当前位置:网站首页>11.1.1、flink概述_flink概述

11.1.1、flink概述_flink概述

2022-06-25 22:12:00 【Loves_dccBigData】

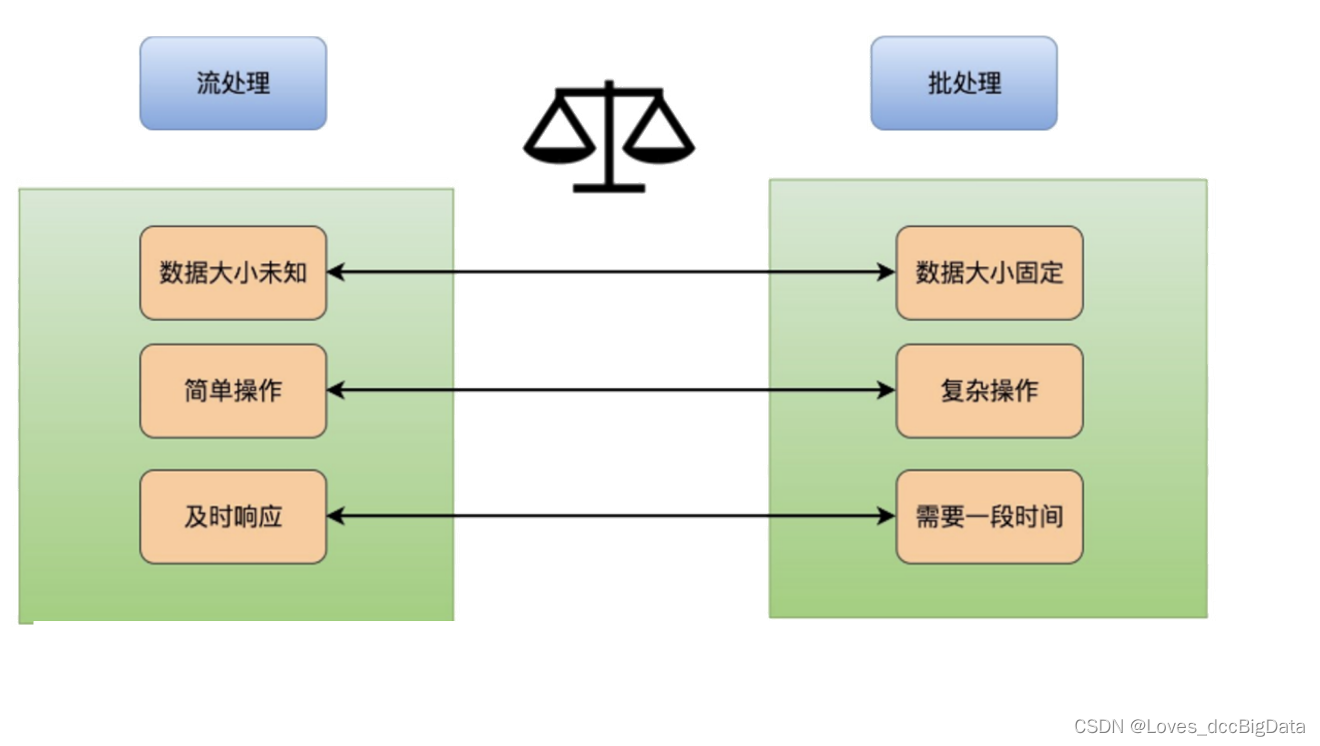

1、流处理和批处理

2、有界流和无界流

有界流:数据量是有限的,eg:mysql等

无界流:数据是没有界限的,一般kafka里数据

3、flink概述,特点

(1)flink是一个分布式的数据处理引擎

(2)支持高吞吐、低延迟、高性能的流处理

(3)支持带有事件时间的窗口(Window)

(4)操作

支持有状态计算的Exactly-once语义

(5)支持高度灵活的窗口(Window)操作,支持基于time、count、session,以及data-driven的窗口操作

(6)支持具有反压功能的持续流模型

(7)支持基于轻量级分布式快照(Snapshot)实现的容错

(8)一个运行时同时支持Batch on Streaming处理和Streaming处理

(9)Flink在JVM内部实现了自己的内存管理,避免了出现oom

(10)支持迭代计算

(11)支持程序自动优化:避免特定情况下Shuffle、排序等昂贵操作,中间结果有必要进行缓存

4、部署环境

(1)本地模式local

(2)cluster集群模式(standalone,yarn)

(3)云模式cloud

5、flink的持续流执行流程(重要)

KeyBy:将相同的key分到同一个Task中

—默认为hash分区

—flink和spark都是粗粒度的资源调度

—称为上游和下游,不叫map,reduce

—flink是一次调度

—一般都是有状态的算子

spark的shuffle过程:

等待map端结束之后再执行reduce端

flink的shuffle过程:

flink中的所有task一起启动,等待数据过来

上游task向下游task发送数据的条件:

(1)数据达到32k(buffle缓存的大小,防止频繁发数据IO消耗)

(2)时间达到200毫秒

6、调度

spark任务调度:

(1)构建DAG有向无环图

(2)切分stage

(3)按照顺序将stage发送给taskschedule

(4)taskschedule将task发送到executor中执行

fink的任务调度

(1)构建DataFlow

(2)拆分成多个task

(3)将所有的task部署启动

(4)等待数据过来,处理数据

7、运行导包

logger为打印日志的,还需要将日志文件放在resources中才可以

<properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<flink.version>1.11.2</flink.version>

<scala.binary.version>2.11</scala.binary.version>

<scala.version>2.11.12</scala.version>

<log4j.version>2.12.1</log4j.version>

</properties>

<dependencies>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-walkthrough-common_${scala.binary.version}</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-scala_${scala.binary.version}</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-clients_${scala.binary.version}</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-slf4j-impl</artifactId>

<version>${log4j.version}</version>

</dependency>

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-api</artifactId>

<version>${log4j.version}</version>

</dependency>

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-core</artifactId>

<version>${log4j.version}</version>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>5.1.36</version>

</dependency>

</dependencies>

边栏推荐

- 给定参数n,从1到n会有n个整数1,2,3,...,n,这n个数组共有n!种排列,按照大小顺序升序排列出所有列的情况,并一一标记,给定n和k,返回第k个值

- Redis之哨兵

- 常用的几款富文本编辑器

- 详解synchronize关键字

- 社交网络可视化第三方库igraph的安装

- 搜索旋转数组II[抽象二分练习]

- 使用百度地图API在地图中设置一个覆盖物(InfoWindow),可自定义窗口内容

- Studio5k V28 installation and cracking_ Old bear passing by_ Sina blog

- keil编译运行错误,缺少error:#5:#includecore_cm3.h_过路老熊_新浪博客

- redis之详解

猜你喜欢

![[wechat official account H5] generates a QR code with parameters to enter the official account attention page to listen to user-defined menu bar for official account events (server)](/img/d9/935bad29005e5846dc514c966e3b0e.png)

[wechat official account H5] generates a QR code with parameters to enter the official account attention page to listen to user-defined menu bar for official account events (server)

Literature research (II): quantitative evaluation of building energy efficiency performance based on short-term energy prediction

One article explains R & D efficiency! Your concerns are

懒人教你用猕猴桃一月饱减16斤_过路老熊_新浪博客

6.常用指令(上)v-cloak,v-once,v-pre

SSM整合学习笔记(主要是思路)

Some common operation methods of array

How to configure SQL Server 2008 Manager_ Old bear passing by_ Sina blog

![寻找翻转数组的最小值[抽象二分]](/img/b9/1e0c6196e6dc51ae2c48f6c5e83289.png)

寻找翻转数组的最小值[抽象二分]

文獻調研(三):數據驅動的建築能耗預測模型綜述

随机推荐

Common problems encountered when creating and publishing packages using NPM

STEP7 master station and remote i/o networking_ Old bear passing by_ Sina blog

Line height for small use

Redis之跳跃表

懒人教你用猕猴桃一月饱减16斤_过路老熊_新浪博客

给定参数n,从1到n会有n个整数1,2,3,...,n,这n个数组共有n!种排列,按照大小顺序升序排列出所有列的情况,并一一标记,给定n和k,返回第k个值

ValueError: color kwarg must have one color per data set. 9 data sets and 1 colors were provided解决

Given the parameter n, there will be n integers 1, 2, 3,... From 1 to n, n. These n arrays have n! An arrangement that lists all columns in ascending order of size and marks them one by one. Given n a

mysql5.7版本在配置文件my.ini[mysqld]加上skip-grant-tables后无法启动

在step7中实现模拟量数值与工程量数值之间的转换_过路老熊_新浪博客

JS中常用知识点

InputStream流已经关闭了,但是依旧无法delete文件或者文件夹,提示被JVM占用等

记录一下刷LeetCode瞬间有思路的一道简单题——剑指 Offer 09. 用两个栈实现队列

How to generate get/set methods in idea

推荐系统设计

Transformation of communication protocol between Siemens S7-200PLC and Danfoss inverter_ Old bear passing by_ Sina blog

P3052 [USACO12MAR]Cows in a Skyscraper G

利用VBScript连接mysql数据库_过路老熊_新浪博客

6. common instructions (upper) v-cloak, v-once, v-pre

[wechat official account H5] generates a QR code with parameters to enter the official account attention page to listen to user-defined menu bar for official account events (server)