当前位置:网站首页>ML笔记-matrix fundamental, Gradient Descent

ML笔记-matrix fundamental, Gradient Descent

2022-06-22 13:53:00 【阿达斯加】

matrix fundamental

basic concepts:

错题:

matrix calculation:

Gradient Descent:

We can speed up gradient descent by having each of our input values in roughly the same range. This is because θ will descend quickly on small ranges and slowly on large ranges, and so will oscillate inefficiently down to the optimum when the variables are very uneven.

The way to prevent this is to modify the ranges of our input variables so that they are all roughly the same. Ideally:

−1 ≤ x(i) ≤ 1

or

−0.5 ≤ x(i) ≤ 0.5

Two techniques to help with this are feature scaling and mean normalization. Feature scaling involves dividing the input values by the range (i.e. the maximum value minus the minimum value) of the input variable, resulting in a new range of just 1. Mean normalization involves subtracting the average value for an input variable from the values for that input variable resulting in a new average value for the input variable of just zero. To implement both of these techniques, adjust your input values as shown in this formula:

Where μ_iμi is the average of all the values for feature (i) and s_isi is the range of values (max - min), or s_isi is the standard deviation.

边栏推荐

- Biden signe deux nouvelles lois visant à renforcer la cybersécurité du Gouvernement

- Mobile learning notes of u++ programming

- 大会倒计时 | 亚马逊云科技创新大会邀您一起构建AI新引擎 !

- 好风凭借力 – 使用Babelfish 加速迁移 SQL Server 的代码转换实践

- 求求了,别被洗脑了,这才是90%中国人的生存实况

- After 17 years, Liu Yifei became popular again: ordinary people don't want to be eliminated, but they also need to understand this

- Database connection pool: stress testing

- Error: Unable to find a match: lrzsz的解决方法

- Common real machine debugging plug-ins for unity commercial games

- 口令安全是什么意思?等保2.0政策中口令安全标准条款有哪些?

猜你喜欢

RealNetworks vs. 微软:早期流媒体行业之争

全新混合架构iFormer!将卷积和最大池化灵活移植到Transformer

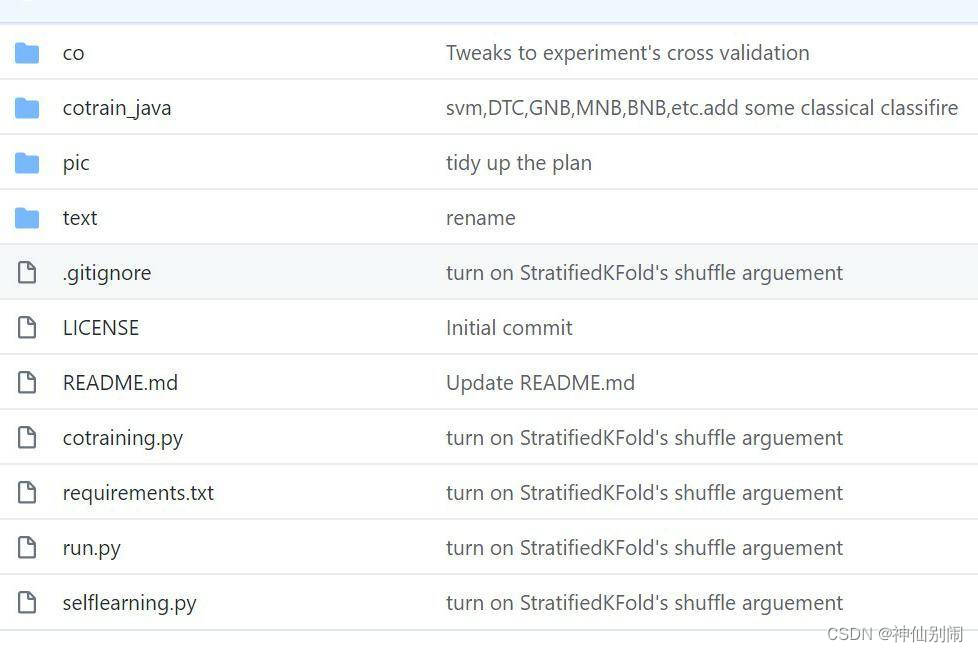

【毕业设计】基于半监督学习和集成学习的情感分析研究

难怪考研热度这么高,这些是研究生才有的“隐藏福利”!

I took a private job and earned 15250. Is it still necessary to do my main business?

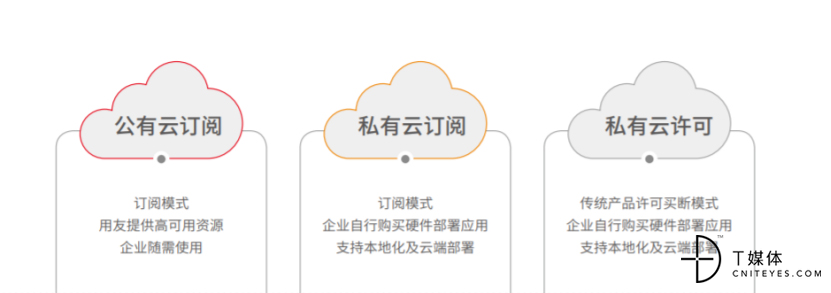

Driving the efficient growth of the manufacturing industry, UFIDA u9 cloud is constantly improving the password behind it

After 17 years, Liu Yifei became popular again: ordinary people don't want to be eliminated, but they also need to understand this

Those confusing user state & kernel state

![[PR] basic process](/img/e6/13a5703cfb8e5c51ed06fe9b0d9485.png)

[PR] basic process

Deadlock found when trying to get lock; Try restarting transaction

随机推荐

What are the five characteristics of network security? What are the five attributes?

Bochs software usage record

Groovy之闭包

KEIL仿真和vspd

Struggle, programmer -- Chapter 48 A thousand gold coins are bought like Fu. Who can complain about this situation

那些令人懵逼的用户态&内核态

Redistemplate serialization

数据库连接池:代码目录

We will resolutely fight and win the hard battle of flood control and disaster relief and spare no effort to ensure the safety of people's lives and property

Biden signs two new laws aimed at strengthening government cyber security

PHP built-in protocols (supported and encapsulated protocols)

What happened to those who didn't go to college

Struggle, programmer chapter 45 tenderness is like water and a good time is like a dream

Fight, programmer chapter 43 kill one man in ten steps

C language student management system (open source)

Struggle, programmer -- Chapter 47 the so-called Iraqis are on the water side

U++ programming array learning notes

C generic method

那些没考上大学的人,后来过的怎样

Sword finger offer46 -- translate numbers into strings