当前位置:网站首页>19 fonctions de perte d'apprentissage profond

19 fonctions de perte d'apprentissage profond

2022-06-28 05:48:00 【Tbyourhero】

Cet article résume19Fonction de perte de semences,Il a été brièvement présenté.Auteur de cet [email protected] mingo_Min.,Pour le partage académique seulement,Le droit d'auteur appartient à l'auteur.,En cas d'infraction,Veuillez contacter l'arrière - plan pour la suppression.

tensorflowEtpytorchBeaucoup sont similaires,VoicipytorchPar exemple.

1. L1Perte de norme L1Loss

Calcul output Et target Valeur absolue de la différence.

torch.nn.L1Loss(reduction='mean')Paramètres:

reduction-Trois valeurs,none: Sans réduction;mean:RetourlossMoyenne de et;sum:RetourlossEt.Par défaut:mean.

2 Perte d'erreur carrée moyenne MSELoss

Calcul output Et target La variance carrée moyenne de la différence.

torch.nn.MSELoss(reduction='mean')Paramètres:

reduction-Trois valeurs,none: Sans réduction;mean:RetourlossMoyenne de et;sum:RetourlossEt.Par défaut:mean.

3 Perte d'entropie croisée CrossEntropyLoss

Quand l'entraînement a C Efficace pour les problèmes de classification des catégories . Paramètres optionnels weight Ça doit être un1Vi Tensor, Les pondérations seront attribuées à chaque catégorie . Très efficace pour les ensembles d'entraînement déséquilibrés .

Dans les tâches Multi - catégories,Souvent utilisé softmax Activer la fonction+Fonction de perte d'entropie croisée,Parce que l'entropie croisée décrit la différence entre deux distributions de probabilité,Mais les réseaux neuronaux produisent des vecteurs,N'est pas une forme de distribution de probabilité.Il faut donc softmaxActivez la fonction pour faire un vecteur“Normalisation”Sous forme de distribution de probabilité,Ensuite, la fonction de perte d'entropie croisée est utilisée pour calculer loss.

torch.nn.CrossEntropyLoss(weight=None,ignore_index=-100, reduction='mean')Paramètres:

weight (Tensor, optional) – Poids personnalisé pour chaque catégorie . Doit être une longueur de C De Tensor

ignore_index (int, optional) – Définir une valeur cible , La valeur cible est ignorée , Pour ne pas affecter Gradient d'entrée .

reduction-Trois valeurs,none: Sans réduction;mean:RetourlossMoyenne de et;sum:RetourlossEt.Par défaut:mean.

4 KL Perte de divergence KLDivLoss

Calcul input Et target Entre KL Dispersion.KL La divergence peut être utilisée pour mesurer la distance entre différentes distributions continues , Dans l'espace de distribution continue de la sortie ( Échantillonnage discret ) Lors de la régression directe Ça marche..

torch.nn.KLDivLoss(reduction='mean')Paramètres:

reduction-Trois valeurs,none: Sans réduction;mean:RetourlossMoyenne de et;sum:RetourlossEt.Par défaut:mean.

5 Perte d'entropie croisée binaire BCELoss

Fonction de calcul de l'entropie croisée pour les tâches de classification binaire . Erreur de mesure de la reconstruction , Par exemple, machine d'encodage automatique . Notez la valeur de la cible t[i] La plage de0À1Entre.

torch.nn.BCELoss(weight=None, reduction='mean')Paramètres:

weight (Tensor, optional) – Personnaliser chaque batch Élément loss Poids. Doit être une longueur de “nbatch” De De Tensor

6 BCEWithLogitsLoss

BCEWithLogitsLoss La fonction de perte met Sigmoid Les couches sont intégrées dans BCELoss Dans la classe. Cette édition est plus simple que Sigmoid Couche et BCELoss Plus stable numériquement , Parce qu'après avoir combiné les deux opérations en une seule couche, , Peut être utilisé log-sum-exp De Techniques de stabilisation numérique .

torch.nn.BCEWithLogitsLoss(weight=None, reduction='mean', pos_weight=None)Paramètres:

weight (Tensor, optional) – Personnaliser chaque batch Élément loss Poids. Doit être une longueur Pour “nbatch” De Tensor

7 MarginRankingLoss

torch.nn.MarginRankingLoss(margin=0.0, reduction='mean')Pour mini-batch(Petits lots) Les fonctions de perte pour chaque instance sont les suivantes: :

Paramètres:

margin:Par défaut0

8 HingeEmbeddingLoss

torch.nn.HingeEmbeddingLoss(margin=1.0, reduction='mean')Pour mini-batch(Petits lots) Les fonctions de perte pour chaque instance sont les suivantes: :

Paramètres:

margin:Par défaut1

9 Perte de classification Multi - étiquettes MultiLabelMarginLoss

torch.nn.MultiLabelMarginLoss(reduction='mean')Pourmini-batch(Petits lots) Pour chaque échantillon, la perte est calculée comme suit: :

10 Version lisse L1Pertes SmoothL1Loss

Aussi appelé Huber Fonction de perte.

torch.nn.SmoothL1Loss(reduction='mean')

Parmi eux

11 2ClassifiélogisticPertes SoftMarginLoss

torch.nn.SoftMarginLoss(reduction='mean')

12 Étiquettes multiples one-versus-all Pertes MultiLabelSoftMarginLoss

torch.nn.MultiLabelSoftMarginLoss(weight=None, reduction='mean')

13 cosine Pertes CosineEmbeddingLoss

torch.nn.CosineEmbeddingLoss(margin=0.0, reduction='mean')

Paramètres:

margin:Par défaut0

14 Classification Multi - catégories hingePertes MultiMarginLoss

torch.nn.MultiMarginLoss(p=1, margin=1.0, weight=None, reduction='mean')

Paramètres:

p=1Ou2 Par défaut:1

margin:Par défaut1

15 Pertes triples TripletMarginLoss

Comme les réseaux jumeaux ,Exemples concrets:Donne - en un.A,Et je le donnerai.B、C,Regarde ça.B、CQui etAC'est plutôt.

torch.nn.TripletMarginLoss(margin=1.0, p=2.0, eps=1e-06, swap=False, reduction='mean')

Parmi eux:

16 Perte de classification des séries chronologiques de connexion CTCLoss

CTC Perte de classification des séries chronologiques de connexion , Les données non alignées peuvent être automatiquement alignées , Utilisé principalement pour la formation aux données sérialisées sans alignement préalable .Comme la reconnaissance vocale、ocrIdentification, etc..

torch.nn.CTCLoss(blank=0, reduction='mean')Paramètres:

reduction-Trois valeurs,none: Sans réduction;mean:RetourlossMoyenne de et;sum:RetourlossEt.Par défaut:mean.

17 Perte de probabilité logarithmique négative NLLLoss

Perte de probabilité logarithmique négative. Pour la formation C Problèmes de classification des catégories .

torch.nn.NLLLoss(weight=None, ignore_index=-100, reduction='mean')Paramètres:

weight (Tensor, optional) – Poids personnalisé pour chaque catégorie . Doit être une longueur de C De Tensor

ignore_index (int, optional) – Définir une valeur cible , La valeur cible est ignorée , Pour ne pas affecter Gradient d'entrée .

18 NLLLoss2d

Perte de probabilité logarithmique négative pour l'entrée d'image . Il calcule la perte de probabilité logarithmique négative par pixel .

torch.nn.NLLLoss2d(weight=None, ignore_index=-100, reduction='mean')Paramètres:

weight (Tensor, optional) – Poids personnalisé pour chaque catégorie . Doit être une longueur de C De Tensor

reduction-Trois valeurs,none: Sans réduction;mean:RetourlossMoyenne de et;sum:RetourlossEt.Par défaut:mean.

19 PoissonNLLLoss

Perte de probabilité logarithmique négative lorsque la valeur cible est la distribution de poisson

torch.nn.PoissonNLLLoss(log_input=True, full=False, eps=1e-08, reduction='mean')Paramètres:

log_input (bool, optional) – Si défini à True , loss Selon le mâle Équation exp(input) - target * input Pour calculer, Si défini à False , loss Sera conforme à input - target * log(input+eps) Calcul.

full (bool, optional) – Calculer tous loss, i. e. Plus Stirling Terme approximatif target * log(target) - target + 0.5 * log(2 * pi * target).

eps (float, optional) – Par défaut: 1e-8

Références:

pytorch loss function Résumé

边栏推荐

- [C language practice - printing hollow square and its deformation]

- Interpretation of cloud native microservice technology trend

- jsp连接Oracle实现登录注册

- JSP

- 电子邮件营销的优势在哪里?为什么shopline独立站卖家如此重视?

- 8VC Venture Cup 2017 - Elimination Round D. PolandBall and Polygon

- Flink window mechanism (two waits and the last explanation)

- 数据仓库:DWS层设计原则

- codeforces每日5题(均1700)

- UICollectionViewDiffableDataSource及NSDiffableDataSourceSnapshot使用介绍

猜你喜欢

RL 实践(0)—— 及第平台辛丑年冬赛季【Rule-based policy】

【Linux】——使用xshell在Linux上安装MySQL及实现Webapp的部署

Jdbc的使用

codeforces每日5题(均1700)

Solution of dam safety automatic monitoring system for medium and small reservoirs

![A full set of excellent SEO tutorials worth 300 yuan [159 lessons]](/img/d7/7e522143b1e6b3acf14a0894f50d26.jpg)

A full set of excellent SEO tutorials worth 300 yuan [159 lessons]

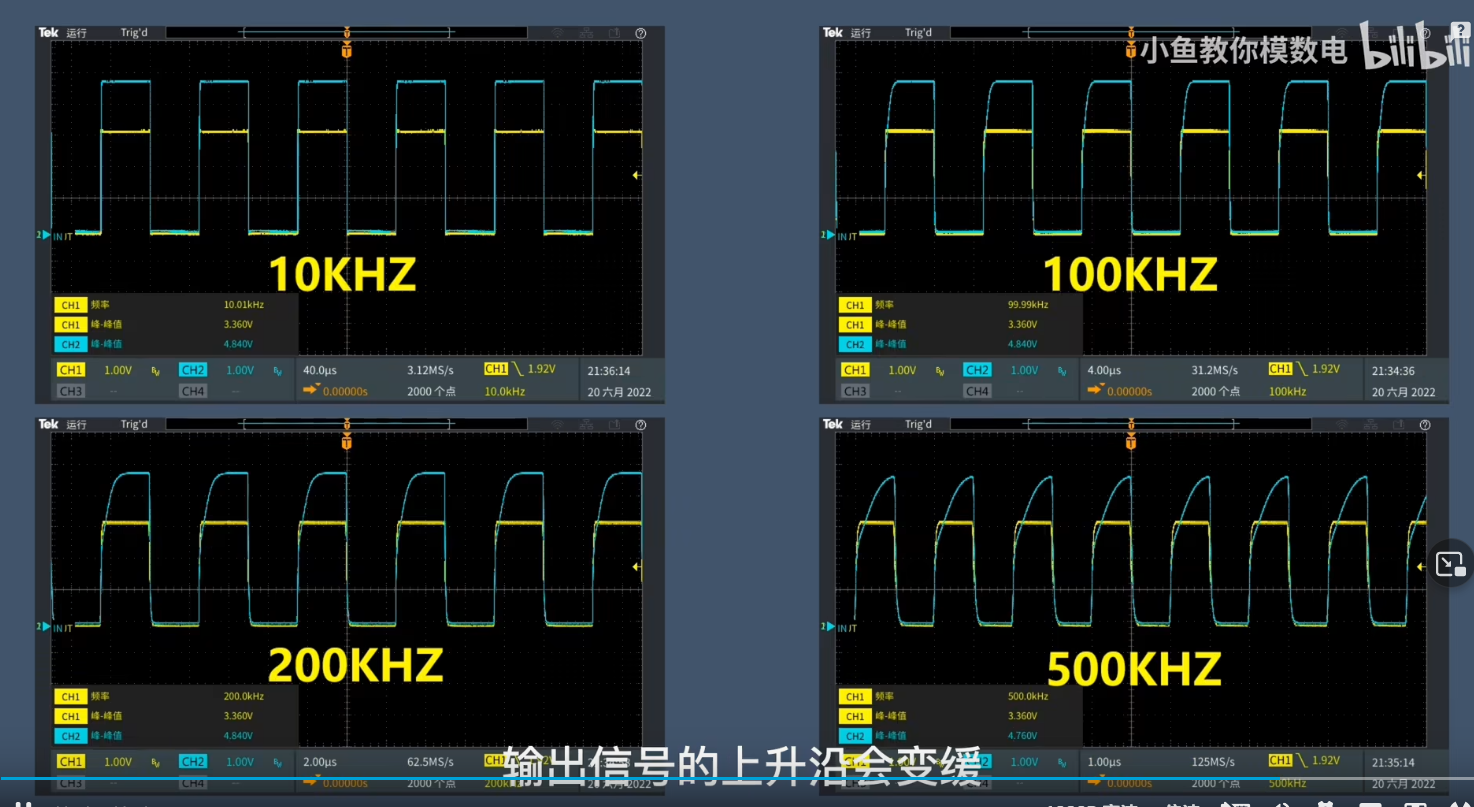

Bidirectional level conversion circuit

Mysql-17- create and manage tables

Prime mover × Cloud primordial is making sound, reducing cost and increasing efficiency lecture hall

Codeworks 5 questions per day (1700 for each)

随机推荐

数据中台:数据治理的七把利剑

电商转化率这么抽象,到底是个啥?

【无标题】

[JVM] - memory partition in JVM

数据仓库:DWS层设计原则

[C language practice - printing hollow square and its deformation]

Filecoin hacker song developer competition

Why is point shield cloud forced to quit playing?

数据仓库:分层设计详解

【JVM】——JVM中内存划分

如何在您的Shopify商店中添加实时聊天功能?

Bidirectional level conversion circuit

JSP connecting Oracle to realize login and registration

Ape pink ape power - Developer activity attack!

Windows环境Redis使用AOF持久化,无法生成AOF文件,生成后无法加载AOF文件内容

MySQL 45 talk | 05 explain the index in simple terms (Part 2)

6. 毕业设计温湿度监控系统(ESP8266 + DHT11 +OLED 实时上传温湿度数据给公网服务器并在OLED显示屏上显示实时温湿度)

Comparison between relational database and document database

Syn retransmission caused by IPVS

Maskrcnn,fast rcnn, faster rcnn优秀视频